| Рубрикатор |  |

|

| Статьи |  |

ИКС № 4 2024 |  |

|

| Николай НОСОВ | 04 сентября 2024 |

Искусственный интеллект и информационная безопасность

И государству, и бизнесу, да и гражданам тоже нужен доверенный ИИ, защищенный от вредоносных воздействий на всех этапах разработки и обучения, соответствующий принятым в стране этическим и правовым нормам.

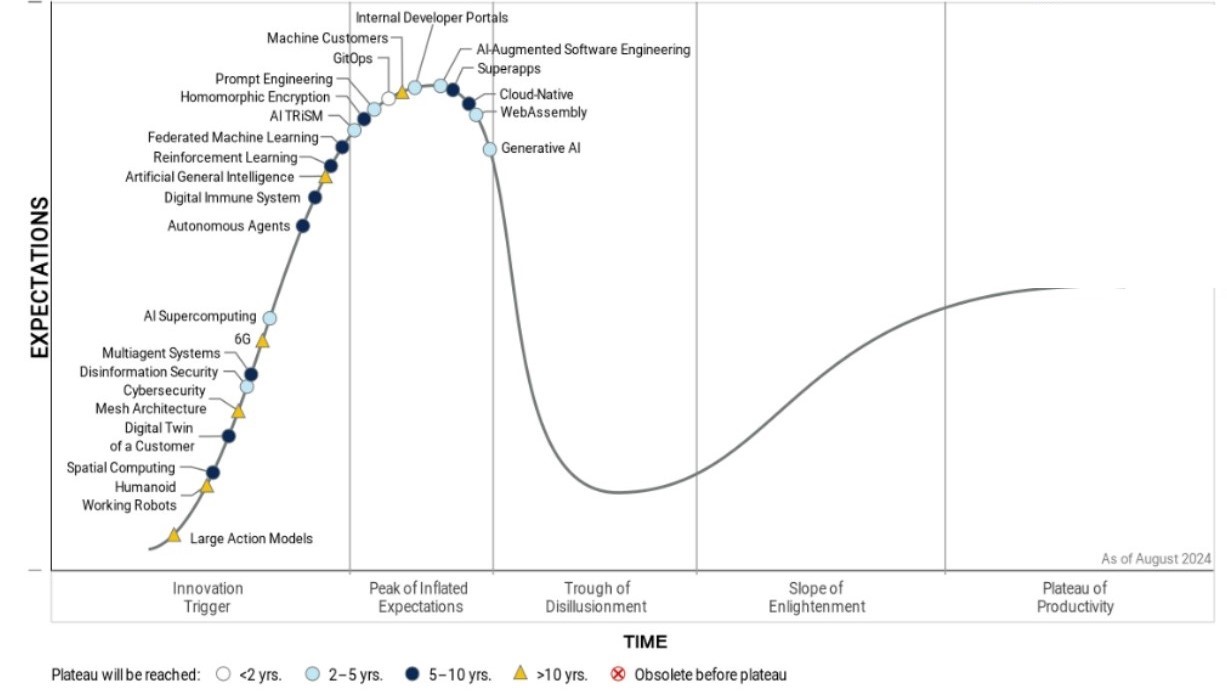

Мода на ИИ

Тема искусственного интеллекта (ИИ, AI) стала самой обсуждаемой в ИТ. На вершине хайпа кривой перспективных технологий Gartner (рис. 1): генеративный AI (GenAI); AI-augmented software engineering – использование технологий искусственного интеллекта, таких как GenAI и машинное обучение, для помощи инженерам-программистам в разработке, кодировании и тестировании приложений; Prompt Engineering – разработка и оптимизация запросов (промптов) для эффективного использования больших языковых моделей, что привело к появлению новой специальности промпт-инженер. Подбираются к вершине: AI TriSM – управление доверием, рисками и безопасностью ИИ, включающее фильтрацию и оценку подлинности контента, соблюдение ИИ-этики и законодательства; Federated Machine Learning – распараллеливание обучения и хранения данных; Reinforcement Learning – обучение с подкреплением, когда система (агент) взаимодействует со средой, параллельно обучаясь и получая вознаграждения за выполнение действий. На горизонте 10 лет просматривается Artificial General Intelligence – сильный искусственный интеллект общего назначения, который способен мыслить и действовать, как человек.

Источник: Gartner

Рис. 1. Цикл зрелости новых технологий

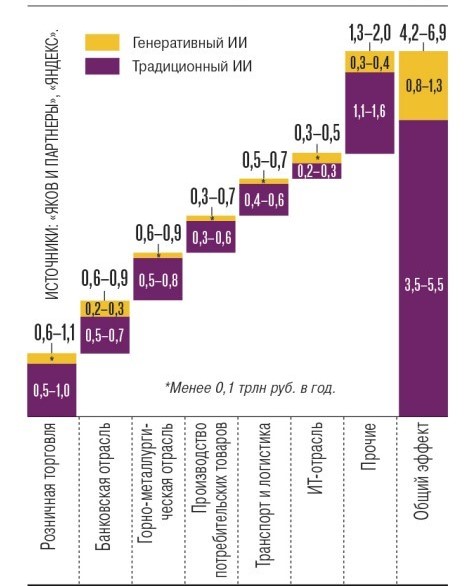

На внедрение технологий ИИ возлагают много надежд. Так, совместное исследование консалтинговой компании «Яков и партнеры» и «Яндекса» оценивает эффект использования технологий ИИ к 2028 г. в 4,2–6,9 трлн руб., или до 4% ВВП. Ожидается, что пятую часть (0,8–1,3 трлн руб.) даст применение генеративного ИИ, создающего тексты, видео и изображения на основе запросов (рис. 2). Основные потребители: ритейл, банки, горно-металлургическая отрасль, производство потребительских товаров, ИТ, транспорт и логистика.

Источник: «Яков и партнеры», «Яндекс»

Рис. 2. Ожидаемый финансовый эффект внедрения ИИ, трлн руб. в год

Новые вызовы

Новые технологии несут новые риски, в том числе в области информационной безопасности. Не исключение и технологии искусственного интеллекта. По сути мы имеем неизвестно как и кем обученный «черный ящик», результаты работы которого проверить, как правило, нельзя. При этом понятно, что по крайней мере на этапе отладки «черный ящик» будет совершать ошибки, а злоумышленники будут пытаться его обмануть или повлиять на ход его рассуждений.

Общие риски использования ИИ назывались не раз:

- этические;

-

потеря рабочих мест;

-

нарушение безопасности и приватности данных;

-

риски для автономных систем под управлением ИИ;

-

формирование зависимости от технологии;

-

отсутствие ответственности;

-

рост социального неравенства.

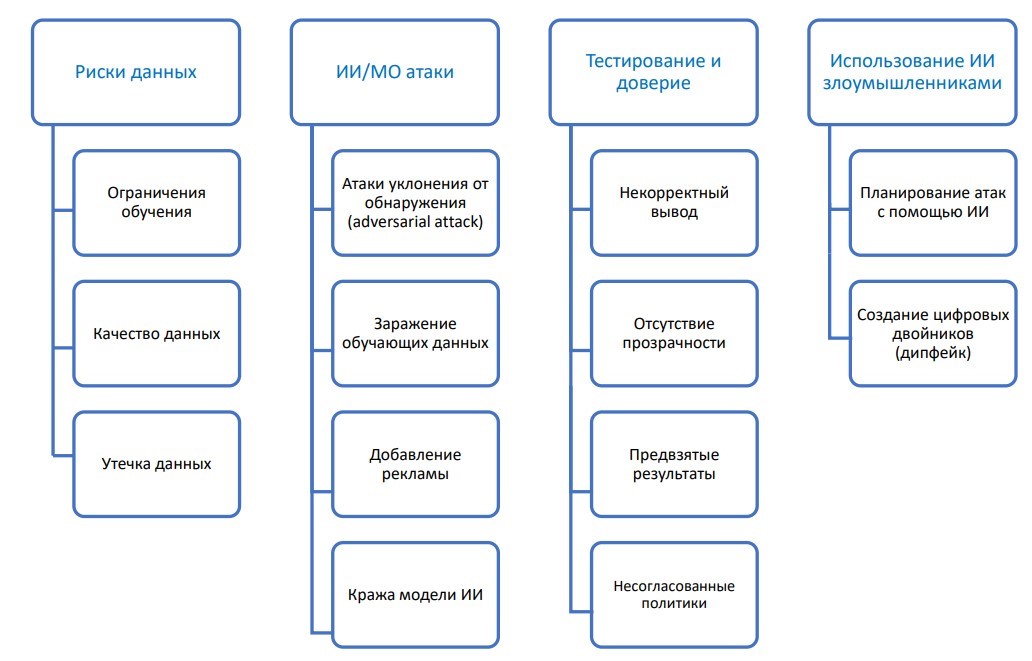

Среди ИИ-рисков советник по стратегии АНО «Национальный технологический центр цифровой криптографии» Петр Ганелин на встрече экспертного сообщества по криптографии и большим данным, посвященной обсуждению темы «Доверенный ИИ», особо выделил риски информационной безопасности: риски, связанные с данными (ограничения, качество, утечки); атаки на ИИ и модели машинного обучения; недостаток доверия и невозможность тестирования модели; использование ИИ злоумышленниками (рис. 3).

Например, путем «отравления» данных (т.е. подачей на вход искаженных злоумышленником тренировочных датасетов) модели можно обучить нежелательному поведению, с помощью специально подготовленных анализируемых данных – обмануть или перенагрузить. А атака инверсии обученной модели может привести к раскрытию конфиденциальной информации. Все это необходимо учитывать в процессе обучения, который должен включать в себя защиту от типичных атак на нейросети.

| |

| Источник: АНО «Национальный технологический центр цифровой криптографии» |

Правонарушитель может использовать ИИ при планировании атаки или изготовлении дипфейков, в которых нейросети добились впечатляющих результатов. Так, более 50 млн просмотров набрал реалистично созданный кинематографическим ИИ студии The Dor Brothers ролик, в котором кандидаты в президенты США и другие известные люди грабят продуктовые магазины.

Дональд Трамп грабит продуктовый магазин. Кадр из ролика студии The Dor Brothers

Риски реализуются через атаки, которые уже осуществляются и развиваются. В популярном у безопасников атласе Mitre перечислены 56 тактик атак, связанных с технологиями ИИ, из которых 14 появились в 2023 г. АНО «Национальный технологический центр цифровой криптографии» выделяет три основных класса атак: на нарушение конфиденциальности, на нарушение целостности и доступности информации (рис. 4).

Источник: АНО «Национальный технологический центр цифровой криптографии»

Рис. 4. Классы атак на ИИ

Нельзя сказать, что все атаки новые. В молодости в аспирантуре, занимаясь тем, что через 20 лет назовут Big Data, выявил особенность на почти идеальном гауссовском распределении усилий при извлечении топливных сборок одного из реакторов. Распределение обрывалось резким пиком при достижении значения N. Как удалось выяснить, N – это технологически установленное предельно допустимое значение, и извлечение сборки с превышающим его усилием могло привести к обрыву троса и аварии на реакторе. За такие действия наказывали лишением премии, и, чтобы не потерять деньги, персонал указывал в отчете не реальное, а предельное значение. В результате исходные данные для моего анализа, нужные для построения многомерной модели конструкции реактора, были искажены, причем не злостными хакерами, а обычными советскими людьми – наглядный пример непреднамеренной атаки путем «отравления» обучающей выборки.

Первые «ответки»

Регуляторы разных стран начали осознавать угрозы использования ИИ и принимать меры к снижению рисков. В области законодательства лидирует ЕС. В марте 2024 г. Европейский парламент принял, а в мае Совет ЕС одобрил закон об искусственном интеллекте (Artificial Intelligence Act), который классифицирует и регулирует использование приложений на основе искусственного интеллекта в зависимости от риска причинить вред пользователю. Исходя из предложенной классификации, продукты ИИ делятся на три категории:

- запрещенные системы (с недопустимой степенью риска);

-

системы с высокой степенью риска;

-

остальные системы искусственного интеллекта.

К запрещенным практикам отнесли биометрическую категоризацию для определения сексуальной ориентации или религии, а также несанкционированное извлечение изображений лиц из интернета и записей с камер наблюдения.

Поставщики и пользователи систем с высокой степенью риска, представляющих угрозу здоровью, безопасности или основным правам человека, должны обеспечивать безопасность и соблюдение действующего законодательства на протяжении всего жизненного цикла систем ИИ. Разработчикам придется раскрывать принципы работы своих технологий и предоставлять датасеты, использованные для обучения систем.

За игнорирование запретов на определенные виды использования ИИ на компании налагается штраф до 35 млн евро или 7% годовой выручки (в глобальном масштабе, если компания транснациональная).

Безопасностью использования ИИ озаботились и в России. В Национальную стратегию развития искусственного интеллекта на период до 2030 г. указом Президента РФ от 15.02.2024 № 124 внесен пункт о необходимости обеспечения безопасности при разработке и использовании технологий искусственного интеллекта.

В мае 2024 г. при поддержке Минцифры в России создан консорциум для исследований безопасности технологий искусственного интеллекта. В числе его участников: Национальный технологический центр цифровой криптографии, Академия криптографии Российской Федерации и Институт системного программирования им. В.П. Иванникова РАН.

По сути, в ИБ появилось новое направление – обеспечение безопасности ИИ, которым занимаются и научные круги, и бизнес. Так, по словам старшего аналитика группы R&D-исследований «Солар» Полины Сокол, в компании выстроена система защиты разрабатываемых моделей, охватывающая все этапы жизненного цикла ИИ-решения. Например, на этапе подготовки обучающего датасета используется кластерный анализ для выявления «ядовитых» данных. Для обеспечения конфиденциальности при хранении исходных данных помимо стандартных средств разграничения доступа применяется гомоморфное шифрование, позволяющее выполнять вычисления на зашифрованных данных без их расшифровки. При использовании open source-компонентов проводится анализ кода и проверка модели на открытых датасетах.

Востребованы и уже появились на кривой Gartner технологии защиты от дипфейков (Disinformation security). Вопросы управления доверием, рисками и безопасностью ИИ, пусть и в упрощенном виде – «роботы отнимут у нас работу, а “Скайнет” всех уничтожит», – широко обсуждаются на телевидении и в СМИ, даже далеких от техники. На уровне Госдумы рассматриваются вопросы этики ИИ, причем к обсуждению присоединилась даже церковь. Ставится вопрос о технологическом суверенитете ИИ – неизвестно, что заложено в ИИ недружественных стран и к каким последствиям приведет их бездумное использование.

Сегодня много делается для создания доверенного ПО, разрабатываемого в соответствии с концепцией жизненного цикла безопасной разработки. Точно так же нужно подходить к построению доверенных моделей ИИ. А для этого нужны совместные усилия науки, бизнеса и государства.