| Рубрикатор |  |

|

| Статьи |  |

ИКС № 4 2024 |  |

|

| Илья БЕДЕРДИНОВ | 29 августа 2024 |

Серверы для ИИ: что предлагают российские производители

Бум интереса к приложениям, использующим искусственный интеллект, привел к росту спроса на соответствующие серверы. Несмотря на сложности, связанные с зависимостью от иностранных комплектующих, российские производители смогли оперативно на него ответить.

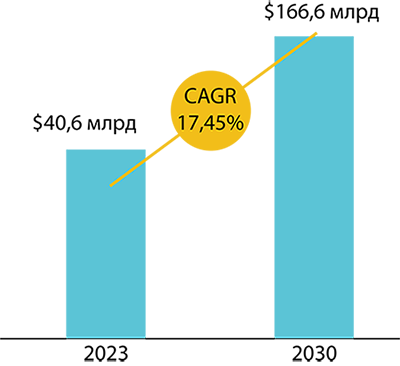

Объем мирового рынка серверов для ИИ-приложений в 2023 г. составил, по данным Verified Market Research, $40,6 млрд, и ожидается, что к 2030 г. он увеличится до $166,6 млрд при среднегодовом росте 17,45%. Более высокий темп роста этого рынка – 34,46% – прогнозирует Market Research Future. По оценкам этой компании, рынок ИИ-серверов составлял $9,75 млрд. в 2022 г. и достигнет $188,35 млрд. в 2032 г. Цифры различаются, но основные драйверы те же – непрерывно повышающийся спрос на ИИ-приложения в разных отраслях и потребность в обработке данных в реальном времени.

Источник: Verified Market Research

Рис. 1. Мировой рынок серверов для приложений, использующих ИИ

Российские эксперты также фиксируют заметный рост спроса на серверное оборудование для проектов, связанных с ИИ. Причем, как отметили в компании GAGAR>N, речь в большинстве случаев идет не просто об исследованиях и перспективных разработках, а о серьезных коммерческих проектах в разных отраслях экономики, предполагающих реальную экономическую отдачу.

«Вплоть до 2023 г. запросов на серверы для ИИ было немного – в среднем мы выполняли два-три проекта в квартал. Сейчас же среди крупных компаний интерес к такому оборудованию увеличился в несколько раз. Есть спрос и со стороны небольших заказчиков – как правило, они выбирают GPU-серверы, которые хорошо масштабируются», – сообщает Андрей Головских, руководитель направления серверного оборудования Crusader компании 3Logic Group.

Не GPU единым

Для обучения больших моделей, как правило, используются графические процессоры (Graphics Processing Unit, GPU), самым известным производителем которых является компания Nvidia. GPU специализируется на обработке графики и параллельных вычислениях. Его главная задача – одновременно обеспечивать визуальное воспроизведение, отрисовку графики и выполнение сложных вычислений. Это делает GPU оптимальным инструментом для трехмерной графики, виртуальной реальности, научной деятельности и многих других областей, где параллельная обработка данных имеет решающее значение.

Однако для ряда задач ИИ использовать графические ускорители необязательно, достаточно CPU новейших поколений. Так, по словам Александра Фильченкова, руководителя управления серверных и сетевых систем компании «Гравитон», ее серверы на базе процессоров общего назначения lntel Xeon Scalable 4-го и 5-го поколений успешно справляются с задачами для ИИ, в частности машинным обучением. Эти процессоры созданы с поддержкой ускорения ИИ в каждом ядре, что обеспечивает скачок в общей производительности, а также снижает совокупную стоимость владения.

Эксперт «Гравитона» обращает внимание на предстоящий выход процессора Intel Xeon 6-го поколения, производительность которого в расчете на 1 Вт должна быть в 2,6 раза выше, чем у предыдущих поколений. «С помощью ускорителей ИИ Gaudi 2 и Gaudi 3 Intel стремится сделать внедрение ИИ более доступным. Эти процессоры предназначены для ускорения выполнения рабочих нагрузок ИИ, особенно в области обучения и выводов генеративного ИИ, и составят конкуренцию решениям Nvidia», – считает А. Фильченков.

Повышенное внимание поддержке ИИ-технологий уделяет и компания AMD, анонсировавшая технологию AMD Instinct AI и серверные процессоры AMD EPYC 5-го поколения. Их выпуск запланирован на второе полугодие 2024 г. По планам производителя, они будут отличаться высокой производительностью и эффективностью при работе с ИИ.

Помимо решений на основе GPU и CPU для приложений на базе ИИ задействуются и другие типы серверов. Например, компания «Тринити» сообщила, что предлагает для этих задач серверы TPU и FPGA. TPU – Tensor Processing Unit – это специализированная интегральная схема (Application-Specific Integrated Circuit, ASIC) ускорителя ИИ, разработанная Google для машинного обучения нейронных сетей с использованием собственного ПО. Google начала применять TPU внутри компании в 2015 г., а в 2018 г. сделала их доступными для сторонних потребителей в рамках своей облачной инфраструктуры, а также предложила уменьшенную версию чипа для продажи. В мае 2024 г. компания анонсировала уже шестую версию – TPU v6.

FPGA (Field-Programmable Gate Array), или программируемая пользователем вентильная матрица – полупроводниковое устройство, которое может быть сконфигурировано уже после изготовления. Серверы с матрицами FPGA позволяют гибко настраивать вычислительные процессы под конкретные задачи ИИ.

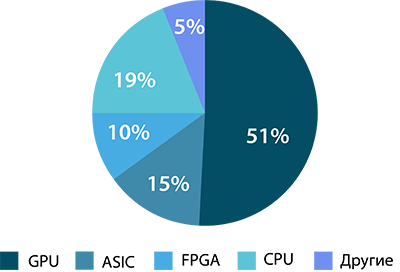

Источник: Global Market Insights

Рис. 2. Доли рынка ИИ-серверов по основным вычислительным компонентам, 2023

На мировом рынке ИИ-серверов решения на базе GPU, по данным Global Market Insights, занимают 51%. На ИИ-серверы с использованием CPU приходится почти 19% рынка, на ASIC (включая TPU) – около 15% и на FPGA – примерно 10% (рис. 2).

Выбор серверов для обучения нейросетей и работы с ними зависит не только от типа процессора, но и от множества таких факторов, как бюджет, требования к производительности, масштабируемости, доступные ресурсы и специфика задачи.

Серверы для ИИ по-российски

Рассмотрим ряд решений, предлагаемых российскими производителями.

Crusader

Под маркой Crusader ИТ-дистрибьютор 3Logic Group предлагает серверы серии Squire HPC с поддержкой до восьми двухслотовых графических ускорителей c ОЗУ типа DDR5 4800/4400 объемом до 6 Тбайт. Топовая модель в портфеле компании – Crusader HPC Squire 4245R – двухпроцессорный сервер (на базе процессора 4-го поколения AMD EPYC 9004) с поддержкой графических ускорителей вплоть до моделей Nvidia Tesla Ada H100.

Рис. 3. Crusader HPC Squire 4245R

Сценарий применения таких серверов определяется потребностями заказчика. По словам А. Головских, оборудование компании используется в первую очередь для интеллектуального анализа данных и обработки естественного языка, в том числе виртуальных помощников и чат-ботов. Такие инсталляции составляют около 80%. На втором месте – задачи компьютерного зрения.

3Logic Group имеет собственные производственные линии, что помогает обеспечивать доступность комплектующих и поставку оборудования, точно соответствующего утвержденной спецификации.

DатаРу

В портфеле продуктов DатаРу представлено оборудование, предназначенное для высокопроизводительных вычислений, включая приложения на базе искусственного интеллекта. ИИ-серверы DатаРу ориентированы на задачи обучения больших языковых моделей, рекомендательных систем, видеоаналитики, анализа данных и симуляции физико-химических процессов. Для обучения ИИ «заточена» модель ПИ ХЕ9680. Младшая модель ПИ 760ХА может использоваться как для обучения, так и для инференса (работы уже обученной модели).

Рис. 4. Сервер ДатаРу ПИ ХЕ9680

В основе модели ПИ ХЕ9680 – восемь модулей GPU Nvidia H100 SXM и процессоры Intel 4-го поколения с объемом оперативной памяти до 2 Тбайт.

Планы развития DатаРу включают расширение линейки ИИ-серверов и возможных конфигураций, а также использование новейших GPU. Например, компании уже готова поставлять оборудование с GPU-модулями Nvidia H200, которые были презентованы компанией Nvidia в ноябре 2023 г. Кроме того, DатаРу собирается в сотрудничестве с ведущими российскими разработчиками систем на базе ИИ расширить список программно-аппаратных комплексов.

Delta Computers

В конце 2023 г. компания Delta Computers представила Delta Sprut, платформу GPGPU (General Purpose GPU), целевое назначение которой, по заявлению компании, – системы искусственного интеллекта, в том числе платформы OpenAI/ChatGPT, машинное обучение, нейронные сети, машинное зрение и перевод, высокопроизводительные вычисления, 3D VDI в задачах проектирования и работе со сложными 3D-моделями.

Рис. 5. GPGPU-платформа Delta Sprut

Платформа Delta Sprut позволяет существенно увеличить возможности подключения PCIe-устройств к серверу: модуль обладает четырьмя разъемами с интерфейсом PCIe x16 и допускает установку четырех карт HHHL или двух карт FHFL. В режиме каскадирования к одному серверу можно подключить до восьми GPU двойной высоты или до 16 GPU стандартной высоты. В Delta Sprut используются GPU Nvidia А100, Nvidia H100 и AMD Instinct, но можно устанавливать графические ускорители и других производителей. Для устройств Nvidia поддерживается попарное объединение мостами NVLink последнего поколения.

В 2016 г. компания Delta Computers стала первым российским участником проекта Open Computer Project (OCP), поэтому неудивительно, что платформа Delta Sprut соответствует стандартам OCP. Как отмечают в компании, у клиентов, которые уже используют в своей инфраструктуре оборудование стандарта OCP, не возникнет проблем при установке нового продукта. При этом серверное шасси Delta Sprut можно интегрировать в 19-дюймовое оборудование.

Представители Delta Computers указывают, что решение компании позволяет сократить затраты на инфраструктуру и энергопотребление. По их словам, объем графической памяти, предоставляемый 40 ОСР-серверами с двумя GPGPU-платформами Delta Sprut, эквивалентен объему, который другие производители могут реализовать только на 80 стандартных 19-дюймовых серверах.

Все продукты Delta Computers, в том числе платформа Delta Sprut, включены в Единый реестр российской радиоэлектронной продукции (ЕРРРП), который ведет Минпромторг.

GAGAR>N

В ответ на рост спроса на серверное оборудование для реализации проектов, связанных с искусственным интеллектом, компания GAGAR>N не только усовершенствовала существующие модели серверов, но и разработала новые специализированные продукты. Решения компании ориентированы как на обучение моделей на основе больших объемов данных (для этого предлагаются модульные масштабируемые системы с большой вычислительной мощностью процессоров GPU), так и на инференс (для этого подойдут модульные серверы с установленными компактными адаптерами).

Основной продукт GAGAR>N для ИИ-задач – это модуль JBOG, занимающий 2U и позволяющий разместить до восьми полноразмерных двухслотовых адаптеров GPU или до 16 однослотовых. Модуль может быть подключен к одному серверу для повышения его производительности либо к нескольким серверам (до четырех) с обеспечением необходимой изоляции.

Для задач инференса пригоден сервер Оракул Gen2 на базе Intel Xeon Scalable 3-го поколения с установленными адаптерами GPU. Сервер имеет до 80 ядер на сервер, 32 слота оперативной памяти DDR4, восемь дисков NVMe/SSD с возможностью горячей замены, четыре накопителя NVMe и два накопителя М.2. Продукт включен в ЕРРРП.

Рис. 6. Сервер GAGAR>N Оракул Gen2

GAGAR>N использует центральные процессоры Intel и GPU-модули от Nvidia. Коммуникационная среда в большинстве проектов реализуется на основе стандарта 100G Ethernet. Для хранения данных рассматриваются программно определяемые решения, причем аппаратной платформой хранения служат серверы с масштабируемой дисковой подсистемой.

Все продукты GAGAR>N отвечают принципам и подходам OCP. При планировании продуктового портфеля компания ориентируется как на мировые технологические тенденции, так и на реальный спрос со стороны российских заказчиков. В перспективе – новые поколения устройств, а также расширение линейки за счет установки процессоров GPU разных форм-факторов и специализированных плат отечественных производителей.

iRU

Для приложений ИИ компания iRU разработала и выпускает сервер Rock G2212IG4. Компоновка сервера позволяет установить до двух полноразмерных GPU-ускорителей, а также два процессора на базе Intel Xeon Scalable 4-го или 5-го поколения и до 8 Tбайт памяти DDR5 ECC REG. В качестве графических ускорителей могут использоваться GPU Nvidia A100 и др. Предусмотрены варианты с 16 накопителями 3,5/2,5” HS (SATA/SAS/NVME), M.2 (Type 2280/22110) SATA и 2,5” HS SATA Rear, что обеспечивает большую пропускную способность и лучшую целостность данных. Сервер имеет слоты расширения, соответствующие стандарту OCP 3.0.

Рис. 7. Сервер iRU Rock G2212IG4

Как отмечают в компании, широкий выбор конфигураций сервера iRU Rock G2212IG4 предоставляет пользователям возможность решать сложные задачи в различных сферах: торговле, медицине, промышленности, логистике, банковском секторе и научных исследованиях. iRU имеет разветвленную сеть сервисной поддержки, насчитывающую, по данным компании, 180 собственных сервисных центров по всей стране.

В ближайших планах iRU – выпуск модели с поддержкой до 10 графических ускорителей.

OpenYard

Для приложений, требующих графических ускорителей, в том числе для задач в области ИИ, машинного обучения и нейросетей, компания OpenYard предлагает сервер RS201. Это GPU-ready решение, в которое может быть установлено до трех графических адаптеров. Модель RS201 поддерживает до 128 ядер (256 потоков), до 8 Тбайт оперативной памяти DDR4, до 780 Тбайт памяти на накопителях NVMe SSD и до восьми плат расширения PCIe в зависимости от реализации. Разъемы PCIe соответствует спецификациям OCP 2.0 и OCP 3.0. Сервер оснащен двумя резервными блоками питания мощностью до 2400 Вт, что должно обеспечивать надежную и бесперебойную работу. Продукт включен в ЕРРРП.

Рис. 8. Сервер OpenYard RS201

Представители OpenYard сообщили, что компания контролирует качество своей продукции с помощью шестиэтапной системы проверки, охватывающей все стадии производства. Для подтверждения надежности серверы после сборки проходят стресс-тестирование в течение 6–8 ч.

Компания планирует расширять существующую линейку, а также разрабатывать как более «легкие» серверы, так и специализированные решения. Вместе со стратегическим заказчиком OpenYard работает над несколькими концептами серверов для видеоускорителей. В ближайшее время они будут представлены рынку. В компании отметили, что готовы к стратегическим альянсам, в том числе в контексте ИИ-разработок.

«Гравитон»

Компания «Гравитон» выпускает несколько моделей серверов, ориентированных на поддержку ИИ-приложений. Как считают в компании, для задач ИИ подходят серверы на базе процессоров Intel Xeon Scalable 4-го и 5-го поколений, построенные на новой материнской плате «Урал» и имеющие до 8 Тбайт оперативной памяти, а также оснащенные большим количеством накопителей (HDD и SSD). Для высокопроизводительных вычислений компания предлагает линейку серверов С2000А с процессорами AMD EPYC. Эти решения построены на материнской плате «Арктика» и могут иметь до 4 Тбайт оперативной памяти. По словам А. Фильченкова, стоимость одного ядра в таком решении почти в два раза ниже, чем у аналогичных продуктов.

Для задач, связанных с генерацией визуального контента на основе технологий ИИ, «Гравитон» предлагает GPU-серверы С2084И форм-фактора Tower/4U на материнской плате «Тундра». Эти серверы могут «нести на борту» до пяти графических ускорителей Nvidia Quadro RTX А5000/А6000 и линейки Nvidia V100/A40/A100.

В плане развития линейки ИИ-серверов компания ориентируется на последние достижения в ИТ-индустрии. В частности, «Гравитон» планирует использовать в своих новых серверах процессоры Intel Xeon 6-го поколения и AMD EPYC 5-го поколения по мере их появления на рынке.

Серверы для ИИ-приложений в числе других решений «Гравитон» включены в ЕРРРП и Реестр российской промышленной продукции Минпромторга.

«Тринити»

Как нам сообщили в «Тринити», для приложений на основе ИИ-технологий, таких как обучение нейронных сетей, обработка и анализ больших данных для выявления закономерностей, видеоаналитика, обработка речи в задачах, связанных с пониманием и генерацией текста, и рекомендательные системы, компания предлагает универсальные платформы, которые могут быть оптимизированы для работы с высокими вычислительными нагрузками. В серверы могут устанавливаться как модули GPU, так и TPU или FPGA.

Компания комплектует свои серверы процессорами Intel Xeon Scalable 4-го и 5-го поколений и AMD EPYC; GPU Nvidia Tesla (серии V100, A100, H100) и AMD Radeon Instinct, а также накопителями NVMe SSD, NAS и SAN для масштабируемого хранения данных.

Почти два десятка моделей серверов «Тринити» включены в ЕРРРП. Компания планирует интегрировать свои решения с облачными платформами.

Сколько ватт на стойку

Для цодостроителей одним из важных следствий бума ИИ может стать существенное повышение мощности серверов, обеспечивающих работу ИИ-приложений. Это может потребовать пересмотра архитектуры системы охлаждения – одного из ключевых компонентов инженерной инфраструктуры ЦОДов. Идут разговоры даже о массовом переходе на прямое жидкостное охлаждение, которое сейчас не используется в большинстве дата-центров, полагающихся на воздушное охлаждение. Какова может быть мощность серверной стойки, «набитой» ИИ-серверами?

Энергопотребление и соответственно тепловыделение серверов в многом определяется конфигурацией и нагрузкой. Например, по данным «Тринити», 1U-серверы обычно потребляют 300–800 Вт, но в зависимости от количества и типа установленных компонентов, таких как высокопроизводительные GPU, потребление может доходить до 800–2000 Вт на сервер.

Как сообщили в компании GAGAR>N, энергопотребление одного модуля JBOG (2U) с восемью адаптерами может превышать 3 кВт, а энергопотребление одного шкафа может доходить до 18 кВт и выше. А по данным iRU, в максимальной конфигурации тепловыделение сервера в пересчете на 1U может достигать 1 кВт.

Получается, что даже если типовую стойку «набить» ИИ-серверами, то общая мощность может составить примерно 40 кВт. (Правда, такая «набивка» необязательно окажется оптимальной с точки зрения экономики проекта.) Но и такое тепловыделение вполне можно снять воздушным охлаждением. Поэтому традиционное охлаждение еще рано списывать со счетов, а массовый переход на прямое жидкостное охлаждение ожидает нас не «прямо сейчас».

От архитектуры до сервиса

Как мы видим, большинство производителей ИИ-серверов используют связку CPU Intel или AMD и GPU Nvidia. Вероятно, сегодня этот подход оптимален по соотношению «цена – качество». Типовой состав таких решений следующий:

- высокопроизводительные CPU (Intel или AMD) с несколькими ядрами и поддержкой многопоточности;

- мощные GPU с большим количеством ядер и высокой производительностью для параллельных вычислений (обычно Nvidia A100, H100);

- большой объем оперативной памяти для обработки больших объемов данных и хранения промежуточных результатов;

- быстрое хранилище данных (NVMe SSD) для минимизации времени доступа к данным;

- высокоскоростные сетевые интерфейсы (100GbE) для быстрой передачи данных между серверами и хранилищами.

Несмотря на понятную ориентацию производителей серверов на GPU Nvidia, полезна возможность использовать в серверах графические ускорители разных вендоров. В условиях санкционного давления такая универсальность даст большую уверенность в дальнейшем развитии инфраструктуры с применением GPU.

Кроме того, при работе со столь сложными решениями, как серверы для ИИ, критически важна техническая поддержка. Поэтому заказчикам следует обратить внимание на наличие разветвленной сети сервисных центров, что позволит быстрее решать вопросы, связанные с работоспособностью серверов.

Как вы могли заметить, в этом обзоре представлены далеко не все отечественные производители серверов. В частности, Kraftway, Nerpa, Sitronics и «Аквариус» на момент его подготовки не предлагали специализированных серверов для ИИ. Но почти не сомневаемся в том, что и эти производители в ближайшее время такие решения

предложат.

Заметили неточность или опечатку в тексте? Выделите её мышкой и нажмите: Ctrl + Enter. Спасибо!