| Рубрикатор |  |

|

| Статьи |  |

ИКС № 3 2022 |  |

|

| Илья Кузнецов | 14 июля 2022 |

Дробим «инженерку» правильно

В хорошем ЦОДе свободные стойки, холод и электроэнергия заканчиваются одновременно. Как совместить наращивание инженерной инфраструктуры с выполнением сертификационных требований к бесперебойности работы дата-центра и использованием возможностей георезервирования?

Как известно, при грамотно спланированном жизненном цикле к моменту, когда в ЦОДе оказываются заняты все стойко-места и заполнены юниты в них, проектные холодильная и электрическая мощности, покрывающие потребности ИТ-нагрузки, также утилизируются полностью. По статистике из открытых источников и сообщениям операторов коммерческих ЦОДов, реальное суммарное потребление электроэнергии клиентским оборудованием составляет 50–75% проектной ИТ-мощности ЦОДа. Таким образом, когда в ЦОДе заканчиваются свободные стойко-места, резервы холодильной мощности, бесперебойного и гарантированного питания обычно еще остаются.

Для оптимизации капитальных затрат с учетом развития ИТ-мощностей ЦОДа целесообразно мощности систем холодоснабжения, бесперебойного и гарантированного питания (СБГЭ) наращивать дискретно. С этой целью рекомендуется на стадии проектной, а еще лучше эскизной документации предусматривать этапность наращивания мощностей за счет установки блоков инженерного оборудования меньшей мощности или последовательного ввода в эксплуатацию элементов инженерной инфраструктуры.

Три сценария

При проектировании ЦОДа стоит рассмотреть несколько сценариев развития инженерной инфраструктуры с учетом наращивания мощности систем холодоснабжения и электроснабжения:

- «Базовый» – 100% планируемой ИТ-нагрузки, согласно техническому заданию, обеспечивается инженерной инфраструктурой сразу, благодаря чему достигается проектное среднее значение ИТ-мощности на одну серверную стойку.

- «50/100» – первоначально устанавливается 50% базового оборудования СБГЭ и кондиционирования с возможностью дальнейшего расширения до 100%. Среднее значение ИТ-мощности на машинный зал или серверное помещение составляет половину максимального.

- «35/75/100» – первоначально устанавливается 35% базового оборудования СБГЭ и кондиционирования с возможностью дальнейшего расширения до 75 и 100% соответственно.

Сценарий 1 – самый простой вариант, как для проектирования, так и для реализации и дальнейшей эксплуатации. В этом варианте все инженерное оборудование устанавливается сразу, а при недозагруженности стоек подключенные мощности будут утилизироваться не полностью. Ситуацию можно улучшить, применив модульные источники бесперебойного питания и устанавливая силовые модули в них по мере роста ИТ-нагрузки, в то время как сами конструктивы ИБП будут смонтированы и подключены ко всем элементам нагрузки сразу.

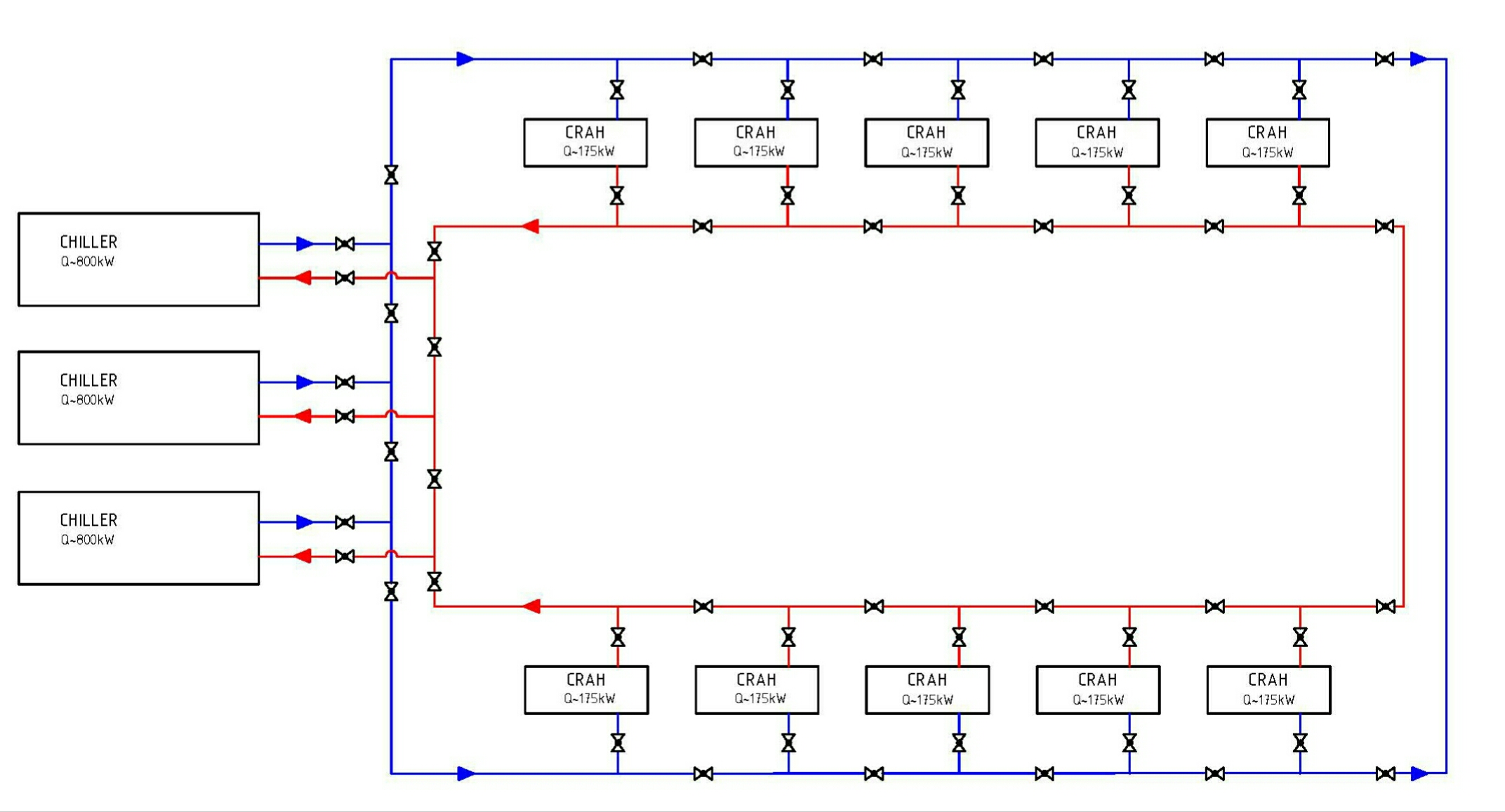

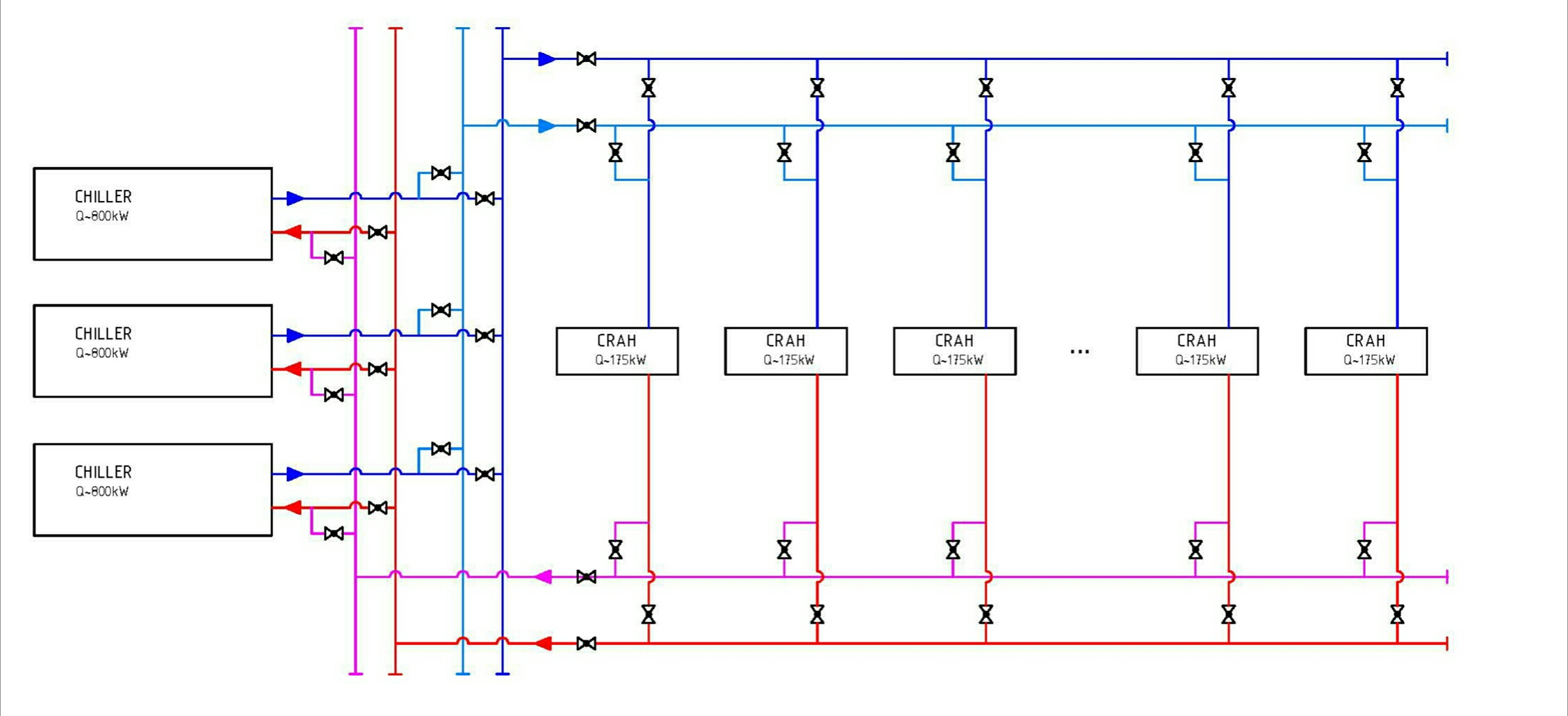

При построении системы кондиционирования и холодоснабжения для обеспечения дискретности в том или ином сценарии следует оказаться от применения единых систем холодоснабжения, охватывающих машинный зал или объект целиком (кольцевых схем (рис. 1) или схем «четыре трубы» (рис. 2) с общими коллекторами и большими холодильными машинами-чиллерами), в пользу набирающих сейчас популярность схем холодоснабжения, в которых один или два внутренних блока кондиционеров (фанкойла) подключаются к одному небольшому чиллеру (рис. 3). Дискретность системы холодоснабжения в этом случае, в том числе для сценария 1, легко достигается установкой необходимого числа комплектов «чиллер – фанкойл». Ввиду ухода основных зарубежных производителей холодильного оборудования для дата-центров и возникшего дефицита холодильных машин большой производительности последняя схема стала сегодня еще актуальнее.

Рис. 1. Схема системы холодоснабжения с кольцевой топологией Tier III

Рис. 2. Схема системы холодоснабжения с топологией «четыре трубы» Tier III

Рис. 3. Схема системы холодоснабжения с топологией «один чиллер – один фанкойл» Tier III/IV

Дискретность системы бесперебойного электроснабжения на статических ИБП в моноблочном исполнении обеспечивается уменьшением номинала ИБП, увеличением их количества и подключением в параллель на общую шину. Увеличение числа единиц оборудования при дроблении по сценариям 2 и 3 приведет к увеличению площади помещений электрощитовых и совокупной стоимости оборудования. Вариант с применением модульных ИБП описан выше. Для сценариев 2 и 3 можно также не устанавливать сразу общие конструктивы ИБП, в которых размещаются силовые модули, а доставлять их на последующих этапах.

Дискретность системы бесперебойного электроснабжения на динамических ИБП или системы гарантированного электроснабжения на ДГУ можно обеспечить установкой необходимого количества оборудования на каждом этапе.

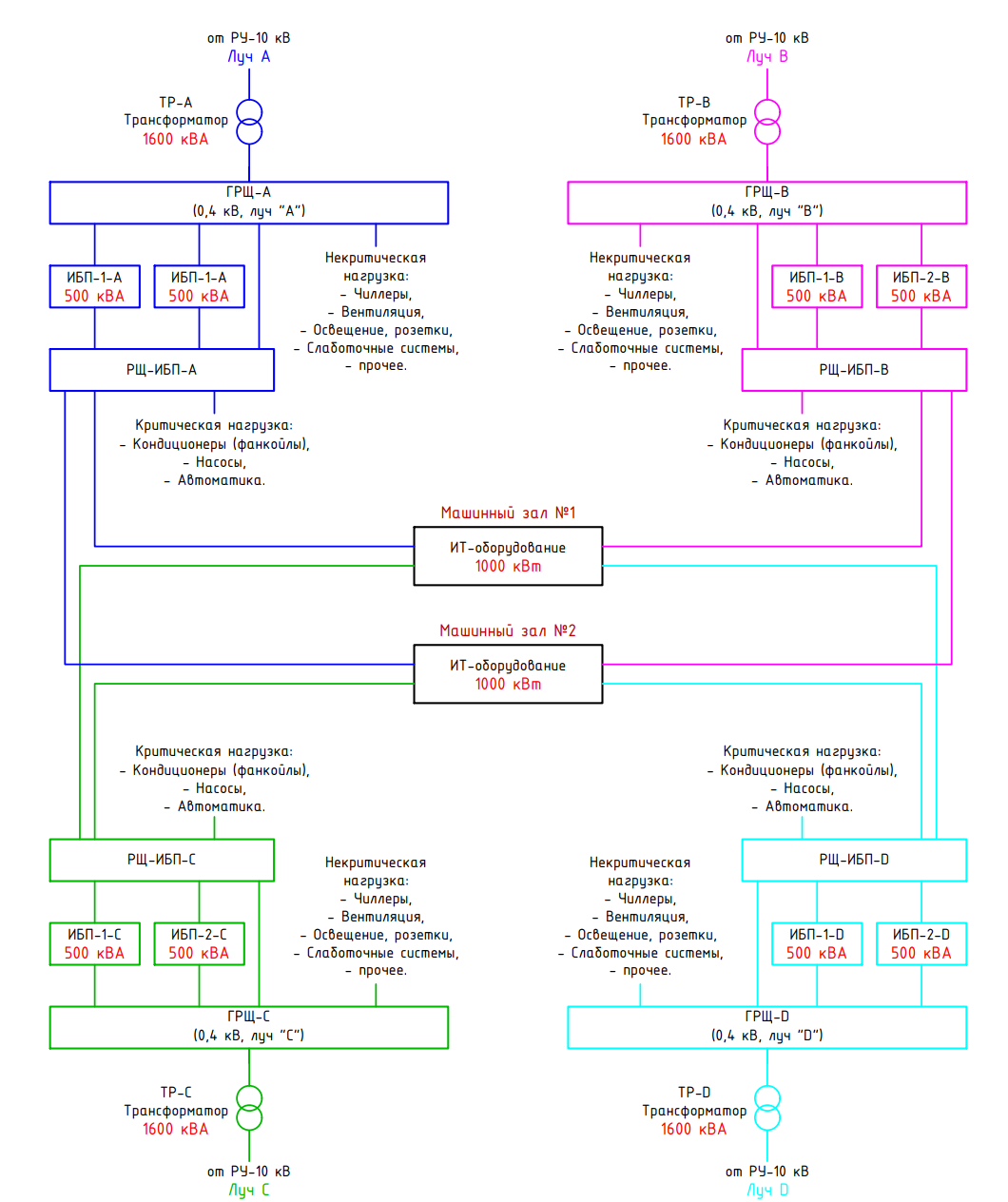

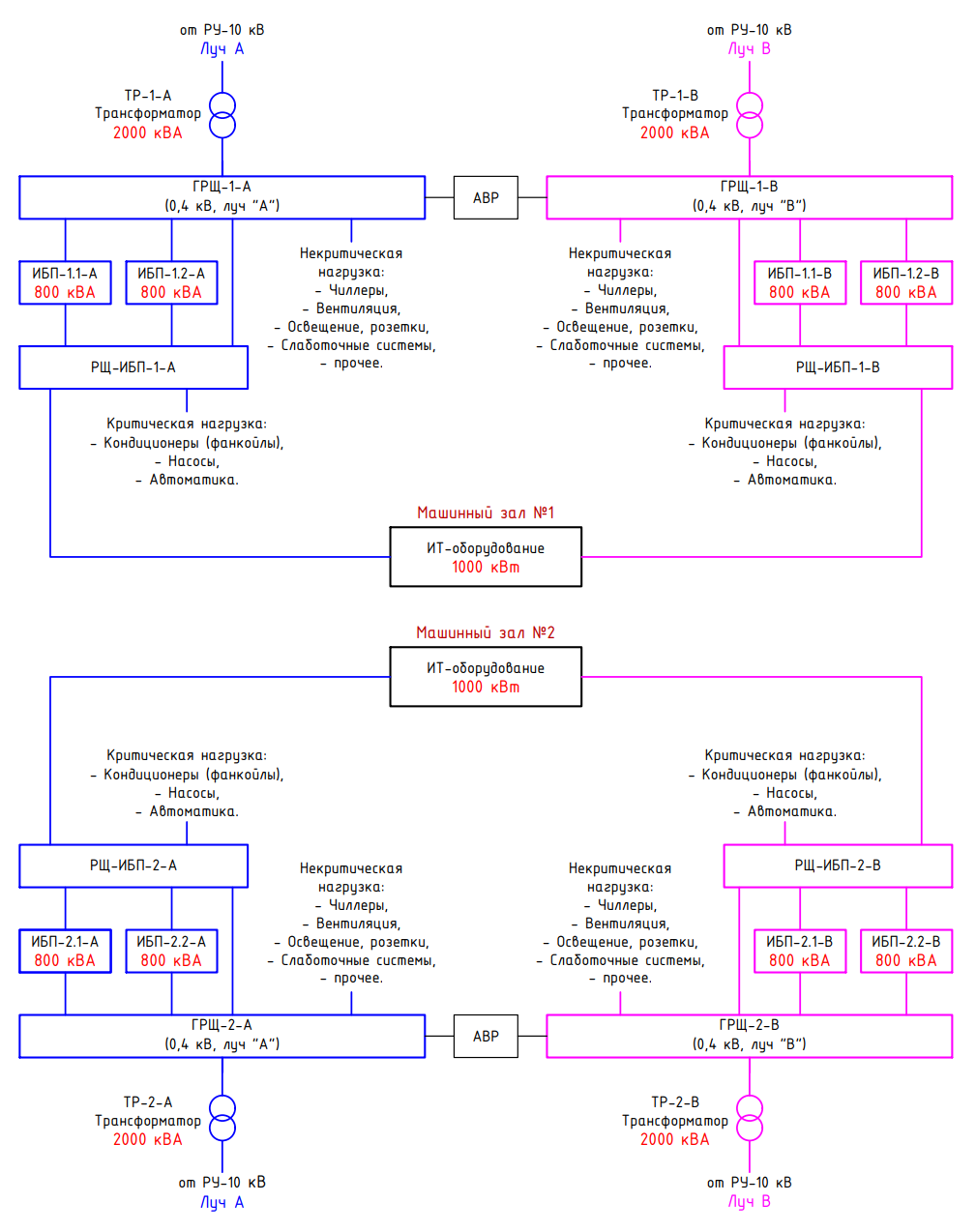

Стоит отметить, что заслужившие в последнее время признание дробные схемы питания нагрузки 3/2N, 4/3N (рис. 4), 5/4N и т.д. не только финансово привлекательны, но и позволяют выше загрузить оборудование (те же ИБП) в нормальном режиме работы, чем классическая схема 2N (рис. 5), и обеспечивают питание критически важной нагрузки по двум активным лучам. Если такие схемы сочетать с использованием модульных ИБП, то можно получить практически идеальную систему бесперебойного электроснабжения. Финансовая привлекательность дробных схем обусловлена возможностью применения оборудования меньшего номинала по сравнению со схемой 2N. Очевидный минус дробных схем – большее количество взаиморезервируемых линий питания, что требует большего места для прокладки трасс и их обслуживания. Кроме того, проектирование и обслуживание таких систем более трудоемко.

Рис. 4. Схема электропитания двух машинных залов по топологии 4/3N

Рис. 5. Схема электропитания двух машинных залов по топологии 2N

Чего потребует сертификация?

Может сложиться впечатление, что все просто: нужно только выбрать сценарий развития ЦОДа с учетом планов и прогнозов его заполнения клиентским оборудованием, спроектировать, построить, ввести в эксплуатацию объект и дожидаться заданной контрольной отсечки для увеличения мощности соответствующих инженерных систем. Но если владельцы ЦОДа для повышения его маркетинговой привлекательности планируют сертифицировать объект в Uptime Institute, то ситуация делается не столь очевидной. При проектировании и создании ЦОДа сертификация будет накладывать ограничения на возможности дробного умощнения оборудования инженерной инфраструктуры.

Для сертификации проектной документации стадии Design в Uptime Institute необходимо выполнить проект в соответствии с требованиями к топологии инженерной инфраструктуры желаемого уровня Tier с учетом заявленных в техзадании средней мощности серверной стойки и ИТ-мощности машинного зала или серверной комнаты. Если сертификация проводится на какой-либо этап развития ЦОДа, то в сертификате будут указаны этап и сертифицируемая ИТ-мощность.

Сертификация стадии Constructed Facility – построенной и сданной в эксплуатацию площадки – потребует испытания работы ЦОДа или его этапа на проектной мощности. Для проведения испытаний нужно будет установить имитаторы ИТ-нагрузки заявленной в сертификате Design мощности и соответствующее инженерное оборудование. Если требуется сертификация каждого этапа ЦОДа последовательно, то на каждом этапе полная проектная ИТ-нагрузка должна обеспечиваться как для испытуемого этапа, так и для всех предыдущих. Это также потребует организовать всю инженерную инфраструктуру, необходимую для поддержания работы ИТ-нагрузки.

Предположим, что развивать ЦОД предполагается этапами. На каждом этапе вводится в строй одна крупная технологическая единица – модуль/блок ЦОДа, который сложно сразу загрузить на проектную нагрузку. Следовательно, для сертификации Uptime Institute площадки, построенной по сценариям 2 или 3, нужно вводить подэтапы, в рамках которых будет наращиваться инженерное обеспечение ИТ-нагрузки. Для этих подэтапов будет последовательно проводиться сертификация в Uptime Institute. Название сертификата Uptime может содержать пометки «Stage 1. Substage 1», «Stage 1. Substage 2» и т.д.

Главный минус такого подхода – необходимость проведения сертификационных испытаний последующих этапов и подэтапов в Uptime Institute стадии Constructed Facility на работающем клиентском оборудовании. С этим сопряжены колоссальные риски возникновения нештатной ситуации в инженерной инфраструктуре во время сертификации и, как следствие, возможные иски клиентов.

Поэтому, если такая сертификация необходима, нужно тщательно разработать программы и методики испытаний на время проведения сертификации и провести тренировки персонала для реагирования на возможные нештатные ситуации с инженерным оборудованием. Приоритетом должно оставаться обеспечение бесперебойной работы клиентского оборудования.

Для проведения сертификации Uptime Institute стадии Constructed Facility сценарий 1 – оптимальный вариант.

На начальной стадии обсуждения проекта ЦОДа нужно трезво оценить, насколько необходимо дробить ввод в эксплуатацию оборудования, даже если понятно, что на начальном этапе загрузка объекта будет далека от проектных значений.

По имеющейся статистике, сегодня среднее потребление одной серверной стойки в коммерческом ЦОДе достигает 3,5–4,0 кВт, тогда как в 2017–2018 гг. этот показатель составлял 2,2–2,5 кВт. Ввиду дальнейшего роста плотности вычислений и удельного потребления электроэнергии ИТ-оборудованием, а также повышения спроса на облачные вычисления, значение этого показателя будет расти. Можно ожидать, что средняя мощность одной стойки в коммерческих ЦОДах через пять-восемь лет достигнет 10 кВт. Следовательно, дискретность установки инженерного оборудования по сценариям 2 и 3 будет не столь актуальна, как сейчас, а ИТ-мощности коммерческих ЦОДов, спроектированных и построенных из расчета 8–10 кВт на одну серверную стойку, с большой долей вероятности будут клиентским оборудованием утилизированы, и сильного дисбаланса в ряду «стойки – холод – электроэнергия» удастся избежать.

Учтем георезервирование

При оценке возможных сценариев развития ЦОДа важно учесть еще один момент, который может быть интересен некоторым пользователям услуг colocation, – георезервирование. Так, ряду клиентов недостаточно иметь высокий уровень резервирования на площадке ЦОДа, ведь вероятность ее отказа все равно остается. Клиенты готовы рассматривать георезервирование уровня кампуса. У комплекса отдельно стоящих зданий с собственной инженерной инфраструктурой вероятность отказа значительно ниже, а между зданиями легко организовать синхронную репликацию данных. Подобной конфигурацией – несколько «спаренных» площадок – для повышения доступности своих сервисов пользуются крупнейшие компании, например НРЕ. С этой точки зрения выгоднее иметь два модуля/блока ЦОДа с развитием по сценарию 2 или 3, что даст возможность сделать уникальное предложение на рынке.

Такой вариант развития также может быть актуален, поскольку в настоящее время в разработке находится значительное количество проектов ЦОДов для colocation, которые готовят компании из различных сегментов рынка: телеком-операторы, девелоперы коммерческой недвижимости и сами ведущие российские операторы colocation, и конкурентная борьба за клиента, по всей вероятности, обострится.

Подведем итоги

Для масштабных проектов целесообразно выполнять эскизное или концептуальное проектирование, в ходе которого оцениваются различные варианты и сценарии реализации инженерной инфраструктуры и рассчитываются CAPEX и OPEX для каждого сценария.

С точки зрения постепенного наращивания мощности ЦОДа и капитальных вложений наиболее рационален сценарий 3, однако для сертификации в Uptime Institute он потребует большей проработки и тщательной подготовки процедур сертификации.

При построении гипермасштабируемых ЦОДов, единицей расширения которых является модуль, следует на начальном этапе реализовать один из вышеописанных сценариев, а далее по мере накопления статистики об утилизации мощностей ЦОДа скорректировать планы развития следующих модулей, выбрав оптимальный для них сценарий.

Илья Кузнецов, директор департамента комплексных проектов,

DCConsult

Заметили неточность или опечатку в тексте? Выделите её мышкой и нажмите: Ctrl + Enter. Спасибо!